😱 Devi davvero rivelare se e quando usi l'AI?

Cosa dice la legge (che non c'è ancora), cosa dice il nuovo codice deontologico dei giornalisti e delle giornaliste (che c'è già), cosa dicono i vip

Secondo Luca Bizzarri, l’intelligenza artificiale è una “contaballe“ e anche una “tentazione demoniaca”. Secondo Aldo Cazzullo, l’umanesimo sta “cedendo a un mondo post-umano, dominato dall’intelligenza artificiale dei cyborg e dalla stupidità naturale dei social”.

Per Paola Mastrocola studiare il latino ci aiuterà a battere ChatGPT (nel 2023 aveva detto che ChatGPT avrebbe distrutto la scuola).

Su LA7, Massimo Gramellini, fra le risate di Giovanni Floris (suo ospite) ha mostrato gli errori che commette DeepSeek se gli chiedi, per esempio, “quali programmi televisivi ha condotto Giovanni Floris”.

Questi sono solo alcuni degli esempi di cose che sono state affermate, con grande visibilità pubblica, sulle intelligenze artificiali nell’ultimo mese in Italia.

Il nuovo codice deontologico dei giornalisti e delle giornaliste

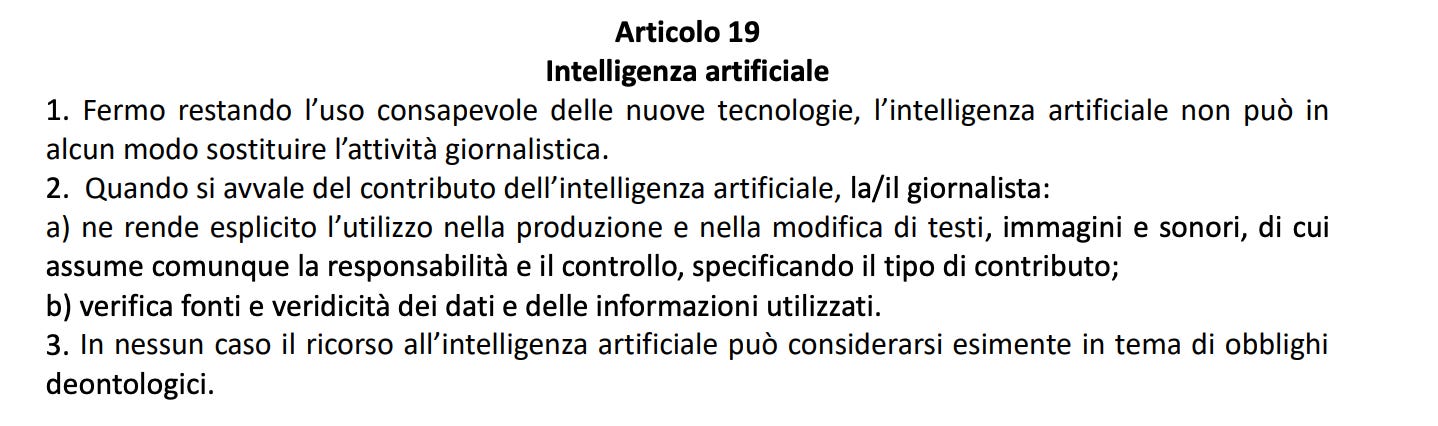

Il nuovo codice deontologico dei giornalisti e delle giornaliste, categoria a cui appartengo, è stato approvato e entrerà in vigore in via definitiva a giugno del 2025. Tratta dell’intelligenza artificiale all’articolo 19.

Sono molto critico nei confronti dei codici vari che dovremmo rispettare, soprattutto perché li guardo e li trovo costantemente aggirati nei modi più fantasiosi. Penso a tutte le volte in cui ho visto trattare in maniera scorretta questioni che hanno a che fare con la nazionalità o comunque le origini di persone protagoniste di fatti di cronaca; penso a tutte le volte in cui ho visto i giornalisti (di solito maschi, ma c’è anche una quota di colleghe a cui piace) blastare laggente. Penso a tutte le volte in cui ho visto i femminicidi minimizzati, le vittime accusate. Penso a tutte le volte in cui ho visto cose di nessuna rilevanza sociale riprese da tutti i giornali – un esempio recente: non c’è nessun motivo giornalistico per parlare di quel che pensa Fabrizio Corona di Jannik Sinner. Se Fabrizio Corona avesse documenti che rivelano qualcosa che non conosciamo, quella sarebbe una notizia. Ma chissenefrega di quel che pensa Fabrizio Corona di un tennista.

Il punto 3 dell’articolo 19 dice: ”In nessun caso il ricorso all’intelligenza artificiale può considerarsi esimente in tema di obblighi deontologici”. Ci mancherebbe altro. Faccio persino fatica a capire perché ci sia bisogno di precisarlo, come se le intelligenze artificiali fossero un campo separato da tutto il resto, come se non fossero una tecnologia, degli strumenti.

Avremmo mai detto “In nessun caso il ricorso alla macchina da scrivere può considerarsi esimente in tema di obblighi deontologici?”.

Il punto 1 dell’articolo 19 dice: “Fermo restando l’uso consapevole delle nuove tecnologie, l’intelligenza artificiale non può in alcun modo sostituire l’attività giornalistica”. Faccio fatica a capire cosa voglia dire, e dovrebbe, comunque, essere detto agli editori, prima di tutto: saranno loro che vorranno automatizzare e pagare ancora meno le persone.

Però, se vogliamo dirlo a giornaliste e giornalisti, allora dovremmo metterci d’accordo su cosa voglia dire “sostituire” e su cosa voglia dire “attività giornalistica”. Se uso un’AI per scrivere il campo ALT di un’immagine o un titolo SEO, è attività giornalistica? Se uso un’AI per scrivermi una scaletta? Una bozza? È attività giornalistica? E fino a che livello d’uso parliamo di “sostituzione”? Se ho raffinato un’intelligenza artificiale con tutti i miei articoli e poi faccio un lungo pitch a voce alla macchina e chiedo di farmi una bozza sulla base di tutto quel che sa di me, del mio stile, del mio pensiero e del modo in cui intendo scrivere l’articolo e degli argomenti che voglio trattare, la macchina mi sta “sostituendo” e dunque è vietato farlo?

E ora tocca al punto 2, che dice: “Quando si avvale del contributo dell’intelligenza artificiale, la/il giornalista:

a) ne rende esplicito l’utilizzo nella produzione e nella modifica di testi, immagini e sonori, di cui assume comunque la responsabilità e il controllo, specificando il tipo di contributo;

b) verifica fonti e veridicità dei dati e delle informazioni utilizzati”.

Il mio commento a 2b) è di nuovo: ma ci mancherebbe altro! Il metodo della verifica è l’unica cosa che distingue il lavoro giornalistico da quello di un’influencer. Perché c’è bisogno di una specificità legata alle AI? E quante volte questa verifica viene davvero praticata quando le AI non c’entrano nulla? Per esempio: quando colleghe e colleghi parlano di prodotti come ChatGPGT o DeepSeek, hanno verificato se abbia senso o meno chiedere a quei prodotti “chi sono io?”?

E infine tocca a 2a) che forse è il passaggio che mi mette più in difficoltà. Io uso le intelligenze artificiali regolarmente per farmi aiutare in questi compiti:

la ricerca delle notizie

fare brainstorming

confutare idee

le scalette

le bozze

la correzione delle bozze

l’analisi dei dati

la trascrizione delle interviste

il reperimento delle citazioni esatte nelle interviste che ho fatto

l’interpretazione di documenti complessi

i riassunti

le meta description

le versioni riassunte dei miei articoli per i social

alcune illustrazioni

le versioni lette dei miei pezzi

alcuni video con il mio avatar

alcuni video diversi da quelli con il mio avatar

altre cose che ora non mi vengono in mente

Nel fare tutto questo, ci sono alcune cose che non vengono mai meno e sono connaturate alla professione giornalistica e non agli strumenti che uso

la relazione con le fonti

la tutela delle fonti

il metodo della verifica

la verifica stessa

il rispetto della deontologia (che per me è molto più stringente di quella scritta nei vari codici e parte dal rispetto delle persone e della ricerca della verità come metodo)

la responsabilità personale nel momento della pubblicazione

Inserirò questo elenco – e per chi è interessato anche il modo in cui lo faccio, facendo divulgazione – nei footer di tutti i posti dove ho una presenza digitale. Di certo non mi metterò a spiegarlo in tutti gli articoli che scrivo.

Il disegno di legge 1146 e le professioni intellettuali

Sul sito del Senato si può seguire l’iter del disegno di legge n.1146 che dovrebbe regolamentare l’intelligenza artificiale nel nostro paese.

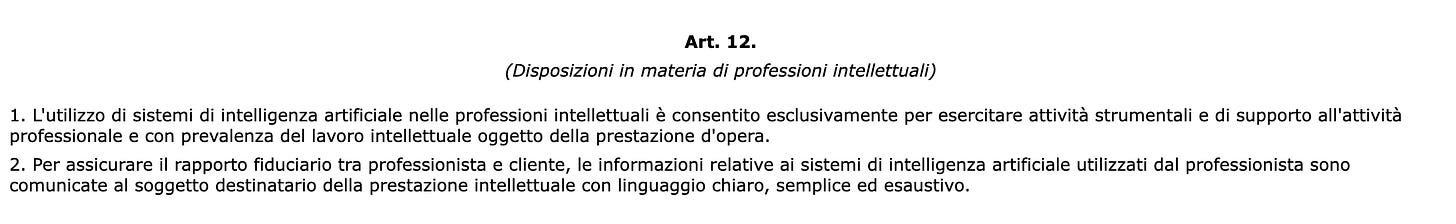

L’articolo 12 parla delle disposizioni in materia di professioni intellettuali. Non sappiamo quando finirà l’iter di discussione e poi come andrà l’approvazione di questa legge, quindi per ora possiamo commentare solo la bozza.

Cosa vuol dire che, nelle professioni intellettuali, l’uso delle intelligenze artificiali è consentito solo per “esercitare attività strumentali”? Che altro dovrebbe fare una macchina se non essere uno strumento? Cosa vuol dire “di supporto all’attività professionale”? Se le uso come supporto a un’attività collaterale della mia attività professionale prevalente, vale? E come si fa a usare per lavoro uno strumento in maniera diversa dal “supporto all’attività professionale”?

Cosa vuol dire “prevalenza del lavoro intellettuale”? Se ho un’idea e poi la faccio eseguire a qualcunə – o a qualcosa –, è prevalente il lavoro intellettuale? Pigiare su dei tasti è lavoro intellettuale? Se la faccio eseguire a qualcunə , perché è diverso? Come dimostro la prevalenza? E come si verifica?

Perché e in che modo dire che strumenti di AI ho usato dovrebbe assicurare il “rapporto fiduciario” con il cliente? Come fa il cliente a verificare? Chi è tenuto a controllare? E come si fa a controllare? Con che carico burocratico nei confronti di chi presta un’opera di lavoro intellettuale?

L’apocalisse

Mentre le normative vanno in queste direzioni distopiche, inapplicabili, disinformate, non controllabili, tutte le esternazioni vippistiche del mondo pop – pure a Sanremo 2025 non si potevano esimere dalla gag con la deficienza artificiale. Che fatica 😮💨 – vanno in un’unica direzione: l’apocalisse, signora mia, l’apocalisse.

Come si resiste all’apocalisse? Si costruiscono anticorpi insieme. Si mettono le barriere a queste idee che non sono né conservatrici né reazionarie ma lo diventano perché disinformate.

Si gioca con le AI. Si impara a usarle. Si decide come. Si usano. Molte persone le usano già senza dirlo per paura o per vergogna. È assurdo e fra un po’ ne rideremo.

Guida antifuffa agli LLM

Qui un rapido riepilogo per evitare di farsi contagiare da quel che fan tuttə , un po’ più tecnico di quel che ci siamo detti fin qui (ma nemmeno troppo).

📌 sì, gli LLM possono “inventare” le risposte

📌 ha poco senso proporre conclusioni definitive rispetto a un nuovo modello, fare affermazioni tipo “questo cambia tutto” o altre cose apodittiche

📌 non ha molto senso chiedere a un LLM “Chi sono io”. Se questa informazione c’è nei suoi dati di addestramento, probabilmente risponderà abbastanza correttamente. Se no, inventerà. Se può andare sul web e glie lo chiedi magari prenderà informazioni da lì. In ogni caso, se non sa chi sei tu non vuol dire che non funzioni

📌 non ha molto senso chiedere a un LLM di fare citazioni letterali, a meno che non si sia fatto un fine-tuning su testi specifici e un po’ di lavoro sul tema. Tendenzialmente, inventerà le citazioni letterali

📌 ogni LLM ha le sue regole imposte da chi li ha programmati e i suoi guardrail. Faccio esempi sparsi: i limiti sono molti altri Gemini non risponde a domande di politica, Claude 2.1 non dice parolacce manco sotto tortura, DeepSeek non parla di Piazza Tienanmen, ChatGPT fa mooooolta fatica a perorare la causa dei palestinesi e via dicendo

📌 ogni LLM ha punti di forza e di debolezza. Tipo: sì, abbiamo capito che ChatGPT non sa(peva) contare quante r ci sono nella parola strawberry. In generale, se vedi errori di questo genere, semplicemente sono legati al funzionamento del modello e poi si correggono

📌 i “guardrail” dei LLM si possono superare (o provare a superare): con strategie metatestuali, usando i numeri al posto delle lettere, con tecniche di PNL, bla la. Ci sono interi progetti dedicati a questo (come il Redarena)

📌 le performance di un modello non si misurano in base a come ha risposto una volta a me o a te. È complicato. Ci sono progetti come Lmarena che aiutano a vedere come va in generale (pure lì si può barare un po’, ovviamente)

📌 le performance di un modello non si misurano in base a quel che dichiara il produttore del modello o a quel che dichiarano i concorrenti del produttore del modello

📌 uno screenshot non serve per analizzare gli output. Serve tutto il contesto, ispezionabile

📌 se un LLM dice di essere qualcosa, questo non significa che sia quel qualcosa. Un modello linguistico generativo produce testo basandosi su probabilità statistiche: non ha una coscienza (al momento), non ha una memoria a lungo termine (salvo configurazioni specifiche), né una vera capacità di autopercezione. Se un LLM dice “Sono ChatGPT”, “Sono DeepSeek”, “Sono un alieno venuto da Marte”, sta semplicemente generando una risposta coerente con i dati con cui è stato addestrato e con il prompt ricevuto

Mercoledì 12 febbraio è uscita la quinta puntata del mio corso sulle AI che si chiama AI@Work e puoi comprarlo qui. Sto anche lavorando al chatbot che ti spiega come funziona. Provalo qui.

Per questa settimana è tutto!

Buon weekend,

Alberto e Jon Slow

Stavo pensando le stesse identiche cose.

Obbligarci a dichiarare se usiamo Ai per fare informazione, in modo così superficiale e generico, é inutile.

Come se al tempo dell’Olivetti fosse stato obbligatorio dichiarare che si usava una macchina da scrivere.

Come se con l’introduzione della suite Microsoft avessimo dovuto dichiarare negli articoli “scritto con il correttore automatico di Word”.

Sui modi poi usati per testare l’Ai e farci articoli ormai é una battaglia persa.

Prendo di nuovo in prestito Olivetti: é come se un giornalista, appena messa sul mercato, l’avesse criticata “perché ho provato a disegnarci e mi lascia solo dei segni di inchiostro senza senso sul foglio bianco”.

Ecco, come la macchina da scrivere non serviva a disegnare - pur avendo inchiostro e comandi - così i large language models non servono a dirti chi é chi, come tu hai giustamente ricordato.

Che ci sia tanta non-voglia di studiare, tanta mancanza di curiosità, un po’ me lo posso aspettare da chi ha esaurito carburante giornalistico (nel senso che posso accettare che chi appartiene a un altro mondo fatichi a codificare il nuovo, fa parte dell’evoluzione).

Il vero problema é un altro: chi invece studia e sa fare divulgazione non ha lo stesso palco in prima serata per parlare a milioni di persone. E non finisce nelle rassegne stampa che poi chi sta in Parlamento, Commissioni Ue ecc… legge per farsi un’idea sul tema (spesso, purtroppo, decisiva nonostante i comitati di esperti a disposizione).

Peró, dai, ci arriveremo.

Molto interessante! Hai messo in ordine e dato spessore a tante riflessioni che tra chi fa giornalismo sono emerse negli ultimi tempi