Epstein Files: "data" vs "capta"

Come creiamo un archivio navigabile, come lo usiamo, cosa ce ne facciamo?

Gli Epstein Files dovrebbero essere la notizia di apertura degli spazi informativi tutti i giorni, se non altro perché dovremmo parlare tutti i giorni di quello che emerge1 dai documenti che sono stati diffusi dal dipartimento di giustizia statunitense. Una rete transnazionale di persone al di sopra di qualsiasi regola, di qualsiasi legge, di qualsiasi morale che vale per le persone ordinarie.

Facciamo un breve riassunto, per quanto complesso.

Cosa sono gli Epstein Files?

Gli Epstein files sono una vasta collezione di documenti, immagini e video (oltre 300 GB di dati) che dettagliano le attività criminali di Jeffrey Epstein e la sua rete di contatti con figure pubbliche, politici e celebrità. Dagli schemi ponzi al traffico di minorenni a scopi sessuali, Epstein si è macchiato di reati disgustosi. Condannato una prima volta nel 2009 con un accordo a lui favorevolissimo, viene arrestato di nuovo nel 2019. Nel frattempo ha intessuto relazioni con ricchi e potenti di mezzo mondo e le vittime (sue e della sua rete) sono diventate decine, probabilmente centinaia. Secondo le dichiarazioni ufficiali, Epstein sarebbe morto suicida nella sua cella il 10 agosto 2019

Dopo anni di teorie del complotto e richieste di trasparenza, nel novembre 2025 il Congresso degli Stati Uniti ha approvato l’Epstein Files Transparency Act, firmato dal presidente Donald Trump. La legge imponeva al dipartimento di giustizia di rendere pubblici i documenti raccolti come prova nei casi penali contro Epstein e i suoi complici, oltre 300 gigabyte di dati archiviati nel sistema di gestione dei casi dell’FBI. I file sono stati pubblicati in due momenti distinti: a dicembre del 2025 e poi il 30 gennaio 2026. Entrambe le pubblicazioni sono state accompagnate da errori grossolani (nomi e foto di vittime esposti) e criteri di oscuramento di nomi e volti non coerenti.

Il rilascio ha già innescato un terremoto politico internazionale. Si sono dimessi alti funzionari e politici in Slovacchia, Svezia e nel Regno Unito (tra cui il barone Peter Mandelson). Turchia, Lituania, Lettonia e Norvegia hanno aperto inchieste per verificare se propri cittadini siano stati coinvolti o trafficati da Epstein. Sebbene avesse promesso trasparenza in campagna elettorale, una volta in carica Trump ha definito parte dei file come “falsificazioni dei democratici”, specialmente dopo che è emerso che il suo nome appariva nei documenti in relazione a testimonianze e accuse non verificate. Mancherebbero, però, moltissimi documenti.

Per molte persone gli Epstein Files sono qualcosa che sapevamo già. E cioè che i ricchi e i potenti hanno regole diverse dagli altri, per esempio. Ma c’è anche un altro fenomeno interessante: nei documenti, ognuno trova quel che vuole trovare. C’è chi ci vede il Mossad in azione. Chi la propaganda russa. Chi le conferme delle peggiori teorie del complotto. In effetti, è facilissimo proiettare qualsiasi convinzione si abbia in qualsiasi pezzo di contenuto dei file. Perché questa collezione, impossibile da navigare senza intelligenze collettive, umane e artificiali, contiene di tutto.

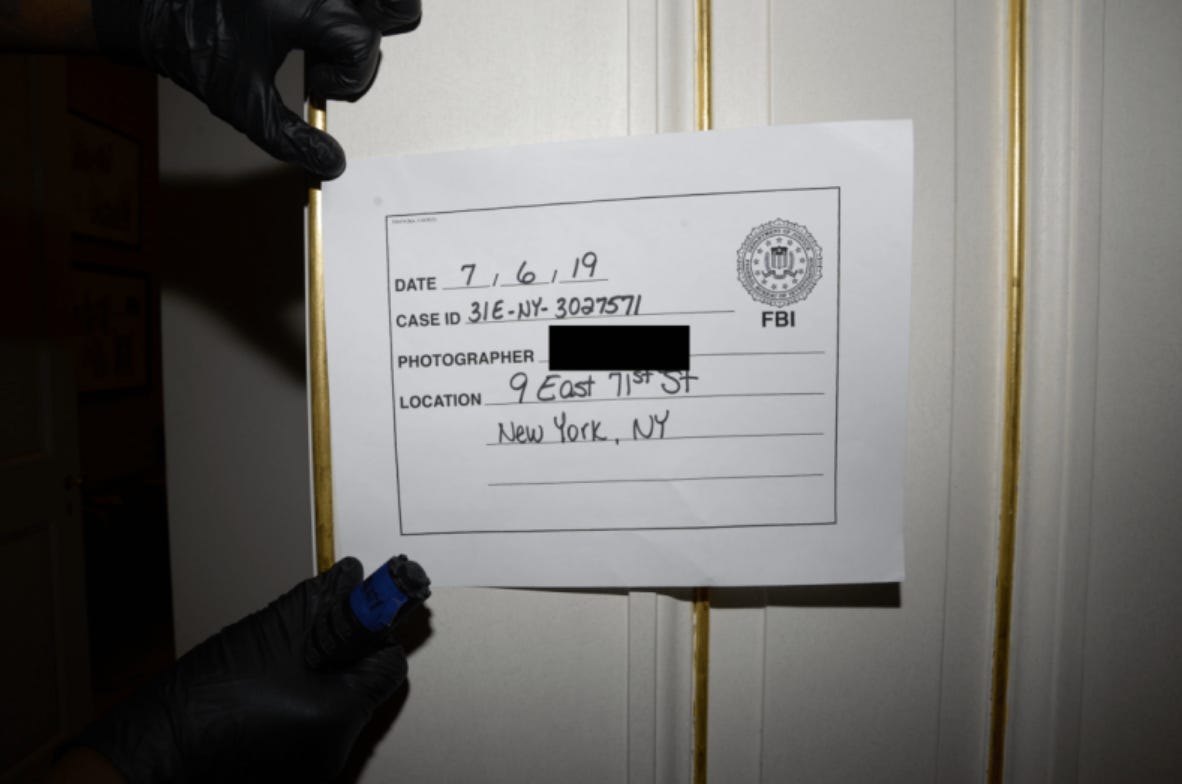

La massa dei dati degli Epstein Files è come una porta che bisogna forzare (proprio come è stata forzata la porta della residenza di Epstein al 9 East 71st di New York) e ispezionare.

Ma non si può forzare e ispezionare senza una mappa e senza un filo conduttore.

Dentro agli atti giudiziari, infatti, ci sono prove. C’è corrispondenza privata. Foto oscurate. Foto non oscurate. File oscurati, in tutto, in parte, in minima parte, per nulla. E ancora: diari delle vittime con ritagli di giornali, mail di persone che si scambiano commenti innocui o idee balzane su come misurare l’intelligenza delle persone, comunicazioni di appuntamenti, alert, richieste di foto con nudi, foto di oggetti sessuali (come una finta vagina in lattice), foto Epstein che chatta con qualcuno e gli mostra oggetti da usare per dominazione, foto di ragazze, foto di persone famose, fotogrammi di film porno oscurati con ancora in sovraimpressione le URL dei siti da cui sono tratti, foto pubblicitarie (se con volti di donna, oscurate), ritagli di giornale, accuse senza conferma, deliri, interrogatori, ricostruzioni, verbali, mail di lavoro di chi indaga, costo della sostituzione delle telecamere del carcere. File excel da 65 colonne e 470 righe in cui ogni cella è un rettangolo nero.

Ora, ci sono molti progetti online che si occupano di rendere gli Epstein File navigabili e interrogabili, ma usarli è sempre un atto di fiducia nei confronti di chi li ha creati.

Costruire un dataset interrogabile

Per questo, ho scaricato tutti i dataset2, nella forma più completa che sono riuscito a trovare e sto ricostruendone la struttura dentro a Pinpoint, uno strumento che individua persone, località e organizzazioni nominate nei documenti; che rende grandi archivi navigabili e cercabili con un motore di ricerca; che li rende anche interrogabili attraverso il large language model di Google, Gemini, vincolato a lavorare solo su quei file per minimizzare errori.

È importante mantenere le categorizzazioni originali e la divisione per cartelle, per una questione filologica e di recupero agevole dei file. L’impresa non è per nulla semplice, vista la mole dei dati e visto il modo in cui sono organizzati.

Il Dataset11, per esempio, è stato reso disponibile in 332 cartelle, ciascuna delle quali contiene centinaia di pdf.

Per lavorare con rigore serve:

verificare le dimensioni dei dataset scaricati;

per i dataset più delicati – almeno tre contenevano materiale pedopornografico e per questo sono stati rimossi da sito ufficiale del dipartimento di giustizia e non sono più disponibili come formato compresso .zip – bisogna fare riferimento a quelli più completi, sincerandosi di non violare leggi;

finito lo scaricamento, bisogna caricarli in Pinpoint, mantenendo i nomi originali dei file (al limite, con una modifica di massa per tenere conto della struttura delle cartelle in cui sono salvati. Per esempio, dopo essermi reso conto della catalogazione in cartelle totalmente disfunzionale, ho fatto in modo di trasformare i nomi dei file così: EFTA02219671.pdf, che fa parte della cartella 0005 del Dataset11, diventa Dataset11-0005-EFTA02219671.pdf. Così si mantiene la nomenclatura originale per permettere a chiunque di ritrovare il file originale. E si mantiene anche la divisione in cartelle;

bisogna poi separare e taggare i file di formati diversi (purtroppo anche le foto sono state diffuse come file .pdf);

infine, usando il sistema di tagging automatico di Pinpoint, si possono taggare, per esempio, per anno o per tipologia di documento;

bisogna anche provare a fare un minimo di rimozione del rumore di fondo: a cosa servono ore di video di telecamere di sorveglianza (probabilmente servivano all’FBI, sono completamente inutili a chi cerchi di dare un senso a questo magma) o 15 fotogrammi di un video con un bip e una scritta bianca su fondo nero “[REDACTED]”? Chiaramente qualsiasi decisione in questo senso va motivata e rigorosamente: anche solo un file rimosso con informazioni usabili, per quanto minime, è una falsificazione.

La preparazione è fondamentale, insomma, e non è per nulla semplic.

Solo dopo si potrà iniziare un lavoro di indagine il cui metodo si può, più o meno, riassumere così:

scavare dentro all’archivio con LLM (a partire da altri articoli, tracce, nomi, idee, parole, o anche per serendipity...) per trovare documenti correlati;

cercare di intuire le ragioni di un nome, una frase, un volto oscurato (tenendo conto di tutte le ipotesi possibili);

ricordare che il solo fatto di essere in quei file non significa assolutamente nulla;

ricostruire i ruoli delle persone nominate che emergono dai documenti (da sottoporre poi a verifica incrociata);

a partire da un numero ristretto di documenti correlati trovati e dopo aver fatto una scrematura, effettuare DeepResearch mirate su fonti aperte, usando quei documenti come fonte e con un piano di ricerca validato con attenzione

verifica umana dei risultati, verifiche incrociate, iterazione del processo fino a che si è ricostruita la storia che si vuole raccontare.

Fare tutto questo dentro una collezione di documenti accessibile e interrogabile con un LLM ha una serie di vantaggi, se si comprendono i limiti dello strumento e si lavora per verificare tutto:

senza automazioni e con la sola forza umana sarebbe impossibile indagare e trovare possibili correlazioni da verificare (questo dovrebbe, finalmente, essere il caso pratico che si aspettava per convincere un altro po’ gli anti-AI che questi strumenti hanno varie utilità intrinseche)

chiunque potrà seguire le tracce che hanno portato alla ricostruzione.

Anche in questa fase, però, servono rigore e lucidità. Serve non farsi trasportare dalle emozioni, dalla rabbia sorda che una storia come questa ti suscita.

Personalmente, dopo essermi immerso nei file, dubito che si troverà al loro interno qualche pistola fumante – a meno che non siano stati commessi errori clamorosi nelle indagini e nella diffusione e redazione3 dei contenuti.

Sono molto più interessato, invece, alle reti, alle connessioni, ai comportamenti di queste élite sfrenate e senza controllo.

Data vs Capta

Se approcciassimo gli Epstein Files come semplici “dati” — ovvero come unità di informazioni oggettive e autoevidenti — cadremmo in un errore fatale. Credere che questi documenti siano uno “specchio della realtà” significa ignorare che ogni pagina è, in verità, un “capta”, cioè una selezione attiva operata da avvocati, inquirenti e funzionari del Dipartimento di Giustizia. Ogni rettangolo nero, ogni “pecetta” che oscura un nome o un indirizzo, è un atto di cattura selettiva che trasforma il dato grezzo in un’argomentazione interpretativa.

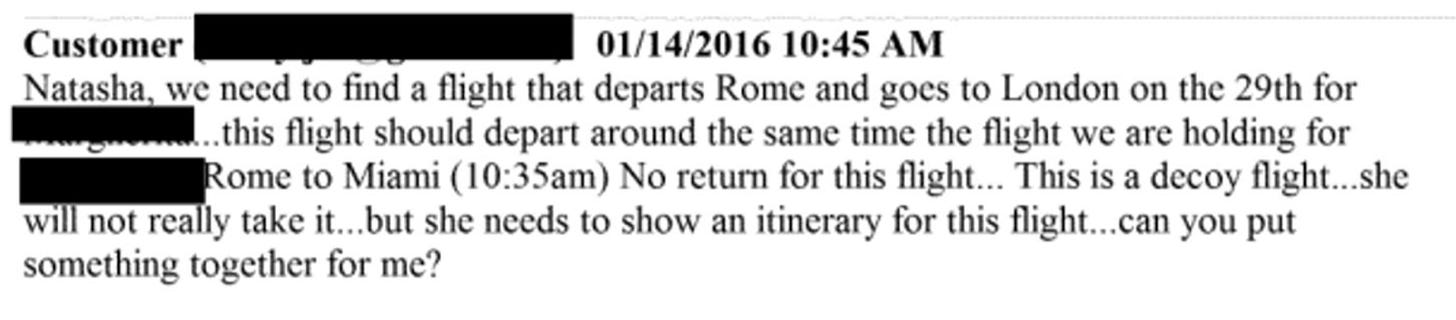

Non solo: anche noi operiamo una selezione attiva quando analizziamo i file. E quella selezione porta altri “capta”. Quando guardiamo il file EFTA02063020.pdf e leggiamo del “volo fake” organizzato da Natasha, non siamo di fronte a un dato neutro, ma a un frammento catturato da un flusso di eventi molto più vasto, strappato dal suo contesto originale e parametrizzato all’interno di un’indagine penale.

Come suggerisce la ricercatrice Johanna Drucker, che ha teorizzato la distinzione fra data e capta, la visualizzazione di questi dataset rischia di diventare un “cavallo di Troia intellettuale” se non ne riconosciamo la natura situata. E può persino essere usata per buttare tutto alle ortiche: nel caos informativo sguazzano sia le teorie complottiste sia quelle negazioniste, che spesso sono funzionali l’una all’altra.

L’uso di un Large Language Model (LLM) per navigare questo magma non serve a “estrarre la verità” in modo meccanico, ma a trasformare il capta in informazione e, auspicabilmente, in conoscenza. Serve a fare emergere l’informazione.

Le intelligenze artificialei ci aiuta a gestire la “capacità” di navigare questa complessità, ma il rigore deve rimanere umano.

Dobbiamo essere consapevoli che anche la nostra ricerca è un atto di “cattura”: decidere di seguire la traccia di un nome rispetto a un altro è un intervento costitutivo che modella la storia che andremo a raccontare.

Gli Epstein Files ci insegnano anche che la trasparenza non è mai un “dato” offerto spontaneamente dal potere o misurato incontrovertibilmente, ma sempre un “capta” strappato con la forza del diritto e della cronaca.

E l’etica di questa indagine risiede proprio nel non dimenticare mai che stiamo maneggiando non numeri freddi, ma frammenti di esperienze vissute, spesso tragiche, che qualcuno ha tentato di ridurre a silenzio amministrativo.

Sostieni questo lavoro

Questa è solo la primissima parte di un lavoro che riguarda gli Epstein Files. Farlo è molto dispendioso in termini di tempo e energie. Se vuoi sostenerci, abbonati a The Slow Journalist oppure abbonati a Piano, la rivista cartacea di Slow News.

Cose da Slow News

🌳 La storia del Parco della pace a Vicenza non è soltanto una storia di rigenerazione urbana. È una storia di guerre e di paci.

😫 La fatica di non fermarsi mai: la sperimentano in molte, ma le persone ADHD un po’ di più.

Cose da leggere

Valeria Coiante ha raccontato a Fanpage un episodio fondamentale della sua carriera giornalistica che dimostra l’importanza di essere sul campo. Quell’episodio coincide con un momento fondamentale della storia dell’Italia. Le monetine lanciate a Craxi.

Per imparare

Lavorare a un progetto come quello sugli Epstein Files richiede anche una conoscenza degli strumenti di intelligenza artificiale che oggi abbiamo a disposizione. Per questo c’è il corso AI@Work.

Il termine non è casuale e ammicca alle proprietà emergenti o ai comportamenti emergenti dei sistemi complessi.

Quelli disponibili facilmente sono dallo 01 allo 09 e poi il 12. Per gli altri ci sono parecchi problemi

Per riferirmi alle “pecette nere” sui documenti, uso i termini “oscurato” o “revisionato”. Sconsiglio, invece, l’uso del termine “censura”, perché presuppone, a mio modo di vedere, intenti malevoli. Il motivo principale per le revisioni e le pecette nere è proteggere le vittime degli orrendi reati commessi.

C'è un'intervista drammatica a viky ward che credo meriti di essere sentita, è nella seconda parte di questo podcast

Today, Explained: The Epstein fallout

Pagina web episodio: https://www.vox.com/todayexplained

File multimediale: https://www.podtrac.com/pts/redirect.mp3/pdst.fm/e/pscrb.fm/rss/p/traffic.megaphone.fm/VMP2782908772.mp3?updated=1770318259

il fatto che i nomi delle vittime siano spesso in chiaro mentre i nomi dei clienti siano spesso redatti la dice lunga sulla qualità e motivazione degli editing di questo "rilascio" di dati.